12.02.2021 | FABIAN DIMSKI

Man könnte meinen, dass es im Jahr 2021 zu einer Binsenweisheit geworden ist, dass hochwertige Daten die notwendige Voraussetzung für erfolgreiche (digitale) Prozesse sind:

„Daten sind das Öl des 21. Jahrhunderts“, „Daten sind das neue Gold“, „Daten sind (so wichtig) wie Wasser“ – fast mantra-artig werden diese Vergleiche seit Jahren bemüht und sollen alle dasselbe unterstreichen:

Ohne (gute) Daten funktioniert im 21. Jahrhundert nichts mehr.

Deshalb wäre zu erwarten, dass mittlerweile jedes Unternehmen seinen Daten auch tatsächlich die entsprechende „Aufmerksamkeit“ widmet, die sie offensichtlich verdienen: dass also die Themen Data Governance (DG) und Data Quality Management (DQM) im Fokus der Geschäftsführung stehen und zentrale Bestandteile des unternehmerischen Handelns geworden sind. Selbstverständlich ausgestattet mit den erforderlichen personellen und finanziellen Ressourcen.

Die Praxis sieht jedoch anders aus: in vielen Unternehmen fristet das Thema Datenqualität noch immer ein Nischendasein, dessen Bedeutung vielfach unterschätzt wird.

Aber leider stellt sich in keinem Unternehmen der Welt hochwertige Datenqualität einfach von selbst ein, sondern sie ist immer das Ergebnis von strategischen, taktischen und operativen Maßnahmen, und zwar auf organisatorischer, prozessualer und technischer Ebene. Das heißt, nachhaltiges DG und zielgerichtetes DQM sind komplexe Herausforderungen.

Vielleicht ist das, neben dem Kostenaspekt, einer der Gründe, dass viele Unternehmen in der Praxis (noch) davor zurückschrecken, sich den Themen strukturiert zu widmen: wo und wie soll man anfangen? Noch dazu, wenn die eigene IT-Landschaft aus Dutzenden oder sogar Hunderten Systemen besteht, und die Prozesse und Daten proprietär und heterogen sind?

Einfache Lösungen gibt es dafür naturgemäß leider nicht. Aber von zahlreichen Herstellern gibt es ausgereifte Data-Governance- und Data-Quality-Systeme, die mit ihren generischen Konzepten und ihrer großen Flexibilität, beliebige „Datenlandschaften“ erfassen und abbilden können, um so die Grundlage für erfolgreiches DG- und DQ-Management zu schaffen.

Denn natürlich gilt gerade für die Datenqualität: If you can’t measure it, you can’t manage it.

Im Folgenden soll deshalb ein Schlaglicht auf ein solches DQ-System geworfen werden, mit dem Datenqualität transparent und damit steuerbar gemacht werden kann. Bayard Consulting begleitet seit fast drei Jahren einen international agierenden Handelskonzern bei Aufbau und Roll-Out des DQ-Systems Data Quality von Informatica.

Ziel dieses Blog-Beitrags soll es natürlich nicht sein, das System umfassend vorzustellen, sondern einen Eindruck über die Einsatzmöglichkeiten des Systems, seine Stärken und auch seine Schwächen zu vermitteln.

Deshalb wäre zu erwarten, dass mittlerweile jedes Unternehmen seinen Daten auch tatsächlich die entsprechende „Aufmerksamkeit“ widmet, die sie offensichtlich verdienen: dass also die Themen Data Governance (DG) und Data Quality Management (DQM) im Fokus der Geschäftsführung stehen und zentrale Bestandteile des unternehmerischen Handelns geworden sind. Selbstverständlich ausgestattet mit den erforderlichen personellen und finanziellen Ressourcen.

Die Praxis sieht jedoch anders aus: in vielen Unternehmen fristet das Thema Datenqualität noch immer ein Nischendasein, dessen Bedeutung vielfach unterschätzt wird.

Aber leider stellt sich in keinem Unternehmen der Welt hochwertige Datenqualität einfach von selbst ein, sondern sie ist immer das Ergebnis von strategischen, taktischen und operativen Maßnahmen, und zwar auf organisatorischer, prozessualer und technischer Ebene. Das heißt, nachhaltiges DG und zielgerichtetes DQM sind komplexe Herausforderungen.

Vielleicht ist das, neben dem Kostenaspekt, einer der Gründe, dass viele Unternehmen in der Praxis (noch) davor zurückschrecken, sich den Themen strukturiert zu widmen: wo und wie soll man anfangen? Noch dazu, wenn die eigene IT-Landschaft aus Dutzenden oder sogar Hunderten Systemen besteht, und die Prozesse und Daten proprietär und heterogen sind?

Einfache Lösungen gibt es dafür naturgemäß leider nicht. Aber von zahlreichen Herstellern gibt es ausgereifte Data-Governance- und Data-Quality-Systeme, die mit ihren generischen Konzepten und ihrer großen Flexibilität, beliebige „Datenlandschaften“ erfassen und abbilden können, um so die Grundlage für erfolgreiches DG- und DQ-Management zu schaffen.

Denn natürlich gilt gerade für die Datenqualität: If you can’t measure it, you can’t manage it.

Im Folgenden soll deshalb ein Schlaglicht auf ein solches DQ-System geworfen werden, mit dem Datenqualität transparent und damit steuerbar gemacht werden kann. Bayard Consulting begleitet seit fast drei Jahren einen international agierenden Handelskonzern bei Aufbau und Roll-Out des DQ-Systems Data Quality von Informatica.

Ziel dieses Blog-Beitrags soll es natürlich nicht sein, das System umfassend vorzustellen, sondern einen Eindruck über die Einsatzmöglichkeiten des Systems, seine Stärken und auch seine Schwächen zu vermitteln.

Data Quality von Informatica

„Data Quality“ von Informatica (kurz IDQ) ist ein Enterprise-System zur Validierung von Daten. Das System ist sowohl als On-Premise-Lösung als auch in der Cloud verfügbar.

Dass einer der „Platzhirsche“ unter den ETL-Tools prädestiniert dafür ist, auch im Bereich Datenqualität ein mächtiges Werkzeug, oder eher noch einen ganzen Werkzeugkasten, bereitzustellen, ist wenig überraschend: denn jede Datenqualitätsprüfung besteht aus diesen drei Schritten:

- Extract: die zu prüfenden Daten werden aus dem/den Quellsystem(en) geladen.

- Transform: die Daten werden den jeweiligen Prüfprozessen unterzogen.

- Load: die Prüfergebnisse werden gespeichert.

Die Umsetzung dieser drei Prozessschritte mit IDQ soll im Folgenden erläutert werden. (Nicht vorgestellt wird dabei die webbasierte IDQ-Analyst-Komponente, mit der sog. Data-Profilings ad hoc auch durch Endanwender möglich sind.)

1. Extract – flexibler Zugriff auf beliebige Datenquellen mit IDQ

1. Extract – flexibler Zugriff auf beliebige Datenquellen mit IDQ

2. Transform – eine gut sortierte Bibliothek für alle Arten der Datenverarbeitung

2. Transform – eine gut sortierte Bibliothek für alle Arten der Datenverarbeitung

3. Load – Erzeugung beliebiger Ausgaben mit IDQ

- beliebige Arten von Quelldaten abbilden können,

- und die Ergebnisdaten für den operativen, taktischen und strategischen Einsatz auf unterschiedlichen Verdichtungsebenen effizient bereitstellen.

Im oben genannten IDQ-Projekt war das Design eines solchen Datenmodells und DQ-Kennzahlensystems eine der zentralen Aufgaben, mit denen Bayard Consulting betraut wurde.

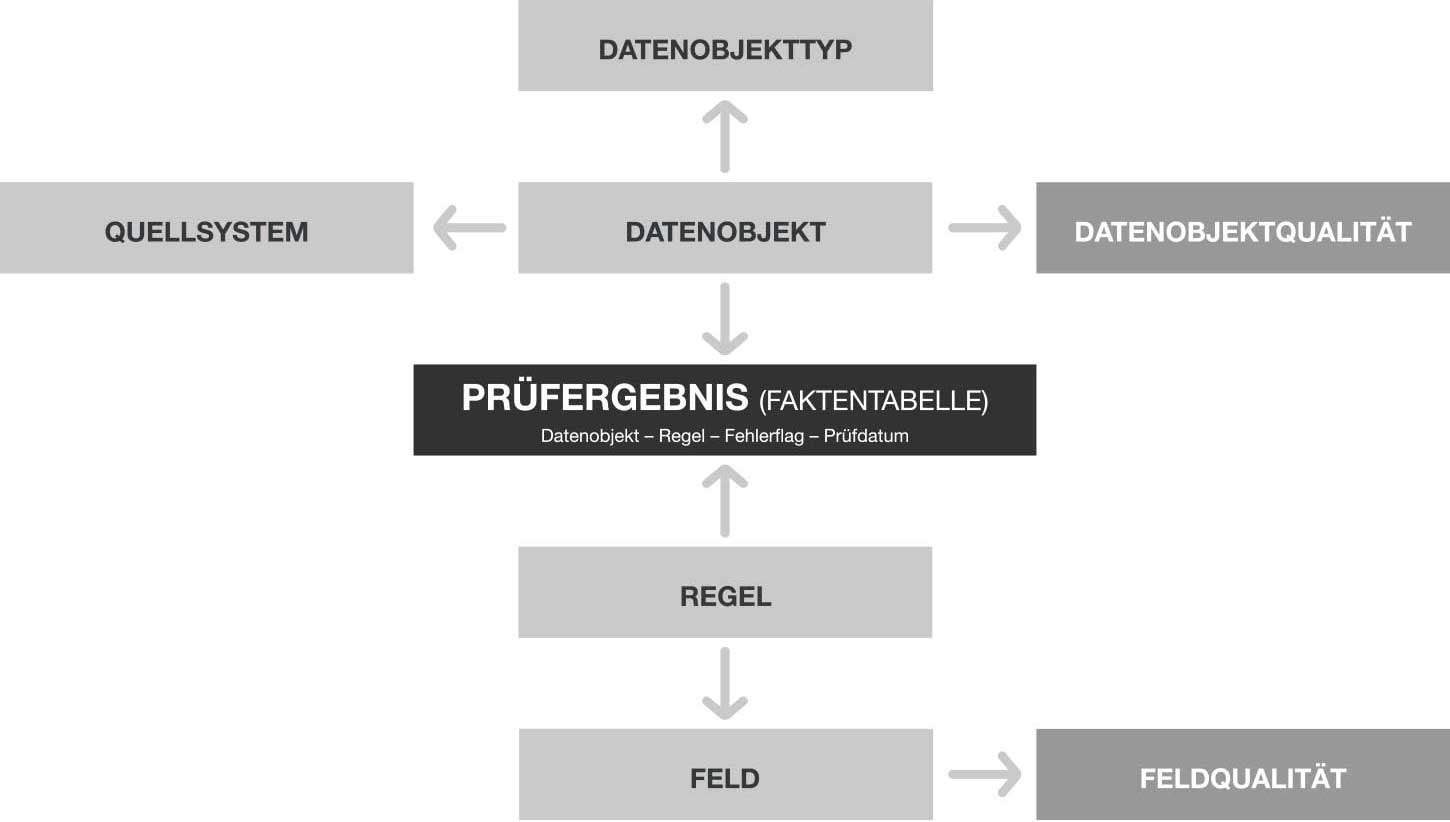

Stark vereinfacht zeigt die nebenstehende Abbildung die Kerntabellen des Modells:

- Als „Prüfgegenstand“ werden sog. Datenobjekte (=Datensätze) aus Quellsystemen in das IDQ-System eingelesen und mit Basisinformationen persistiert.

- Jedes Datenobjekt wird einem Datenobjekttypen zugeordnet, um bspw. für ein Handelsunternehmen Lieferantendatensätze von Produktdatensätze zu unterscheiden. Aber natürlich ist mit diesem generischen Ansatz die Abbildung beliebiger Anwendungsdomänen möglich.

- Um die Datenqualität zu messen, werden (Validierungs-)Regeln definier

- Die Regeln werden jeweils genau einem (Daten-)Feld zugeordnet, das sie prüfen.

- Bei jeder Ausführung der IDQ-Workflows entstehen so zahlreiche Prüfergebnisse, die das binäre Prüfergebnis (Fehler? JA/NEIN) einer Regel für ein spezielles Datenobjekt repräsentieren.

- Diese granularen Prüfergebnisse werden einerseits direkt als Fehlerlisten ausgespielt, um die einzelnen Datenfehler im operativen Tagesgeschäft in den Quellsystemen zu bereinigen. Zusätzlich werden basierend auf den Prüfergebnissen DQ-Kennzahlen für die Datenobjekte (Datenobjektqualität) sowie für die geprüften Felder (Feldqualität) berechnet, die zur taktischen und strategischen Auswertung auf unterschiedlichen Verdichtungsebenen genutzt werden können. So kann bspw. die Datenqualität eines ganzen Quellsystems, einzelner Datenobjekttypen oder auch einzelner Felder im Zeitverlauf ausgewertet werden, um daraus organisatorische, technische oder prozessuale Maßnahmen abzuleiten.

3. Load – Erzeugung beliebiger Ausgaben mit IDQ

- beliebige Arten von Quelldaten abbilden können,

- und die Ergebnisdaten für den operativen, taktischen und strategischen Einsatz auf unterschiedlichen Verdichtungsebenen effizient bereitstellen.

- Als „Prüfgegenstand“ werden sog. Datenobjekte (=Datensätze) aus Quellsystemen in das IDQ-System eingelesen und mit Basisinformationen persistiert.

- Jedes Datenobjekt wird einem Datenobjekttypen zugeordnet, um bspw. für ein Handelsunternehmen Lieferantendatensätze von Produktdatensätze zu unterscheiden. Aber natürlich ist mit diesem generischen Ansatz die Abbildung beliebiger Anwendungsdomänen möglich.

- Um die Datenqualität zu messen, werden (Validierungs-)Regeln definiert.

- Die Regeln werden jeweils genau einem (Daten-)Feld zugeordnet, das sie prüfen.

- Bei jeder Ausführung der IDQ-Workflows entstehen so zahlreiche Prüfergebnisse, die das binäre Prüfergebnis (Fehler? JA/NEIN) einer Regel für ein spezielles Datenobjekt repräsentieren.

- Diese granularen Prüfergebnisse werden einerseits direkt als Fehlerlisten ausgespielt, um die einzelnen Datenfehler im operativen Tagesgeschäft in den Quellsystemen zu bereinigen. Zusätzlich werden basierend auf den Prüfergebnissen DQ-Kennzahlen für die Datenobjekte (Datenobjektqualität) sowie für die geprüften Felder (Feldqualität) berechnet, die zur taktischen und strategischen Auswertung auf unterschiedlichen Verdichtungsebenen genutzt werden können. So kann bspw. die Datenqualität eines ganzen Quellsystems, einzelner Datenobjekttypen oder auch einzelner Felder im Zeitverlauf ausgewertet werden, um daraus organisatorische, technische oder prozessuale Maßnahmen abzuleiten.

4. (K)ein Frontend – Visualisierung der DQ-Ergebnisse mit BI-Systemen

IDQ ist (abgesehen von der oben kurz erwähnten Analyst-Applikation) primär ein Backend-System. Das bedeutet, dass für die Visualisierung der Ergebnisse der Datenqualitätsprüfungen Dritt-Systeme integriert werden sollten, wenn sich die Endanwender nicht äußerst bescheiden mit Excel-Dateien zufriedengeben.

Prädestiniert dafür sind selbstverständlich sog. Business-Intelligence-Lösungen (BI), die es in großer Zahl am Markt gibt und die in vielen Unternehmen, unabhängig vom Thema „Datenqualität“, bereits im Einsatz sind. Neben bspw. Tableau, Microsoft PowerBI oder Qlik gehört auch Microstrategy zu diesen BI-Tools, mit denen in kurzer Zeit dynamische und flexible Dashboards und Reports erstellt werden können, um die DQ-Ergebnisse bedarfsgerecht und zielgruppen-spezifisch bereitzustellen.

4. (K)ein Frontend – Visualisierung der DQ-Ergebnisse mit BI-Systemen

IDQ ist (abgesehen von der oben kurz erwähnten Analyst-Applikation) primär ein Backend-System. Das bedeutet, dass für die Visualisierung der Ergebnisse der Datenqualitätsprüfungen Dritt-Systeme integriert werden sollten, wenn sich die Endanwender nicht äußerst bescheiden mit Excel-Dateien zufriedengeben.

Prädestiniert dafür sind selbstverständlich sog. Business-Intelligence-Lösungen (BI), die es in großer Zahl am Markt gibt und die in vielen Unternehmen, unabhängig vom Thema „Datenqualität“, bereits im Einsatz sind. Neben bspw. Tableau, Microsoft PowerBI oder Qlik gehört auch Microstrategy zu diesen BI-Tools, mit denen in kurzer Zeit dynamische und flexible Dashboards und Reports erstellt werden können, um die DQ-Ergebnisse bedarfsgerecht und zielgruppen-spezifisch bereitzustellen.

Fazit

Das Enterprise-ETL-System Data Quality von Informatica ist ein funktionsmächtiger Werkzeugkasten, um Transparenz über die tatsächliche Datenqualität in der gesamten IT-Landschaft eines Unternehmens zu gewinnen und existierende Probleme zu identifizieren.

Seine Stärken hat das System insbesondere mit Blick auf seine hervorragenden Integrationseigenschaften einerseits, die den Zugriff auf alle Arten von Daten erlauben, und andererseits hinsichtlich seiner Transformationsbibliothek, die jede Art von Datenprüfung ermöglicht.

Entscheidend ist hierbei allerdings, dass die Anwendung dieses Werkzeugkastens sehr strukturiert, standardisiert und dokumentiert erfolgt, um eine hohe Wiederverwendbarkeit der Komponenten und kurze Entwicklungszyklen zu erreichen.

Zum Funktionsumfang von IDQ gehört ausdrücklich kein benutzerfreundliches Frontend. Deshalb ist die Anbindung eines BI-Systems zur Visualisierung der DQ-Ergebnisse ratsam.

Mit den richtigen Konzepten in puncto Ergebnisdatenmodellierung und DQ-Kennzahlensystem kann mit Data Quality von Informatica eine umfassende Datenbasis aufgebaut werden: damit schafft IDQ die notwendige Voraussetzung für erfolgreiches Data Quality Management.